Qual è il nostro strumento di analisi preferito per la SEO?

Screaming Frog.

Abbiamo quindi chiesto a Raffaele Visintin, Seo Specialist, Beta tester di Screaming Frog e autore dello Screaming Frog Club, di darci qualche consiglio sull’utilizzo di questo strumento. Cosa ne è venuto fuori?

Una vera e propria guida sui 5 errori da non commettere quando si tratta di SEO.

Buona lettura e buon esercizio!

La Seo rimane imprescindibile per l’authorship dell’azienda perché permette alle aziende di qualunque dimensione e settore di crescere e diventare remunerative.

Ovviamente la Seo non è immediata, non regala nulla e non bastano pochi attributi, qualche tag da inserire nel codice Html o il passepartout del semaforo verde di Yoast per emergere in un contesto altamente competitivo.

Ma il bello è proprio questo, una materia composta da infinitesimi elementi che devono essere equilibrati e mixati per ottenere la benevolenza del pubblico e del leader Maximo: Google.

Screaming Frog rappresenta il mezzo per iniziare a destreggiarsi in questo scenario. Attraverso questo crawling spider sarai in grado di eseguire analisi tecniche avanzate, integrare i dati con le API di terze parti e sostenere la crescita del tuo progetto.

Quindi se credi che la Seo non serva o ancor peggio sia morta ecco per te 5 consigli “Non richiesti” che credo possano comunque aprirti una nuova visione, altrimenti se sei convinto come me che il posizionamento organico sia una soluzione da perpetrare per il successo del tuo business benvenuto onboard!

Evita i contenuti duplicati

“The Content is the King” per Google e rappresenta uno dei fattori più importanti per il ranking!

Le regole da seguire sono 2 e sono molto semplici.

1. Non copiare dal compagno di banco (concorrente, risorse online);

2. Non copiare da te stesso.

Se il primo punto è molto chiaro e i contenuti devono essere freschi, originali e ben scritti semanticamente, il secondo è uno degli errori che trovo maggiormente durante gli Audit Seo sui siti web ed e-commerce dei clienti.

Ma cosa significa copiare da se stessi?

Il concetto è banale ma dannatamente complicato: i contenuti delle pagine del tuo sito web devono rispondere a Search Intent diversi ottenuti dallo sviluppo di contenuti con keyword set ottimizzati, mentre nella prassi molti siti web presentano sezioni con pagine simili o addirittura identiche che inesorabilmente consumano il crawling budget, non creano valore per il navigatore e, di conseguenza, rappresentano un ostacolo per il ranking creando cannibalizzazione delle query.

L’obiettivo di un Seo professionista quindi non si deve limitare a comprendere e ottimizzare le pagine identiche ma deve porre attenzione anche a quelle con alta similarità.

Grazie a pochi accorgimenti, e con Screaming Frog, sarai in grado di scoprire sia i contenuti duplicati esatti, sia contenuti simili e tutto questo in pochi minuti:

1. Abilita “Near Duplicates” tramite ‘Config > Content > Duplicates‘.

Screaming Frog di default riesce ad identificare le pagine identiche e per scoprirle dopo la scansione sarà sufficiente consultare la colonna “Hash” dalla tab “Internal”, mentre per identificare i contenuti con alta similarità sarà sufficiente abilitare l’opzione “Enable Near Duplicates”.

Per farlo andare su: ‘Config > Content > Duplicates’.

Di base il Seo Spider considera una pagina come “simile” se presenta una corrispondenza minima del 90%; questo range lo potrai modificare in base al tuo progetto e alla capillarità di analisi da mettere in campo!

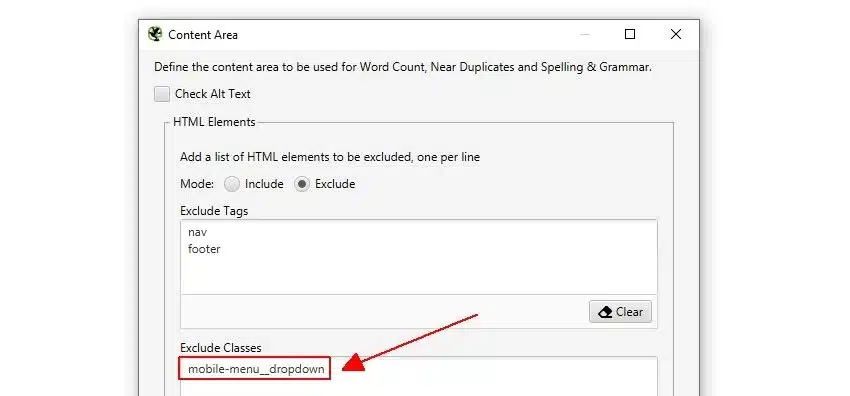

2. Regola la sezione di contenuto da analizzare

Anche per questa task Screaming Frog è molto flessibile e ti permette di scegliere il focus su cui porre l’attenzione nella ricerca di contenuti duplicati o simili.

La configurazione standard di Screaming Frog esclude automaticamente gli elementi della <nav> e del <footer> e si basa sul corpo principale ma puoi personalizzare l’analisi includendo o escludendo specifici tag HTML, classi o ID in base al tuo progetto.

3. Crawlera il tuo sito web.

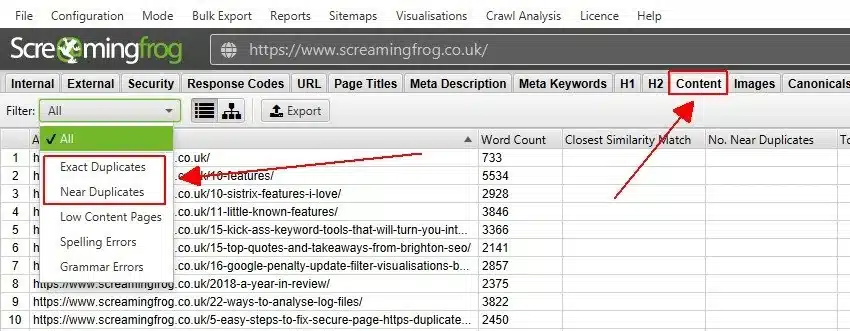

4. Consulta i risultati e rispettive similarità nella tab “Content” della finestra superiore del Seo Spider utilizzando come filtri “Exact Duplicates” e “Near Duplicates”.

Maggiori dettagli li trovi nella finestra inferiore sulla tab “Duplicate Details”.

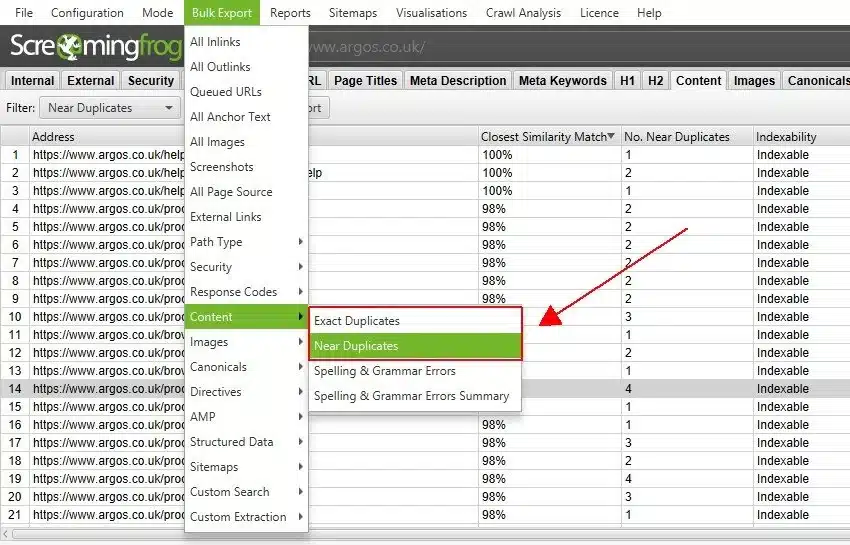

5. Esporta i risultati da: Bulk Export>Content>Near Duplicates

Non abbandonare le tue pagine in un’isola deserta

Le “Orphan Pages” rappresentano le pagine che non ricevono alcun collegamento interno ma, nonostante questa condizione, sono presenti in Serp grazie a Link esterni che le hanno portate all’attenzione del Motore di Ricerca.

Questo scenario è molto comune dopo una migrazione e deve essere gestito attraverso un reindirizzamento, uno status code 410 (Gone) oppure una modifica dell’Internal Linking.

Per scoprire se anche il tuo sito web presenta questa anomalia ti basterà:

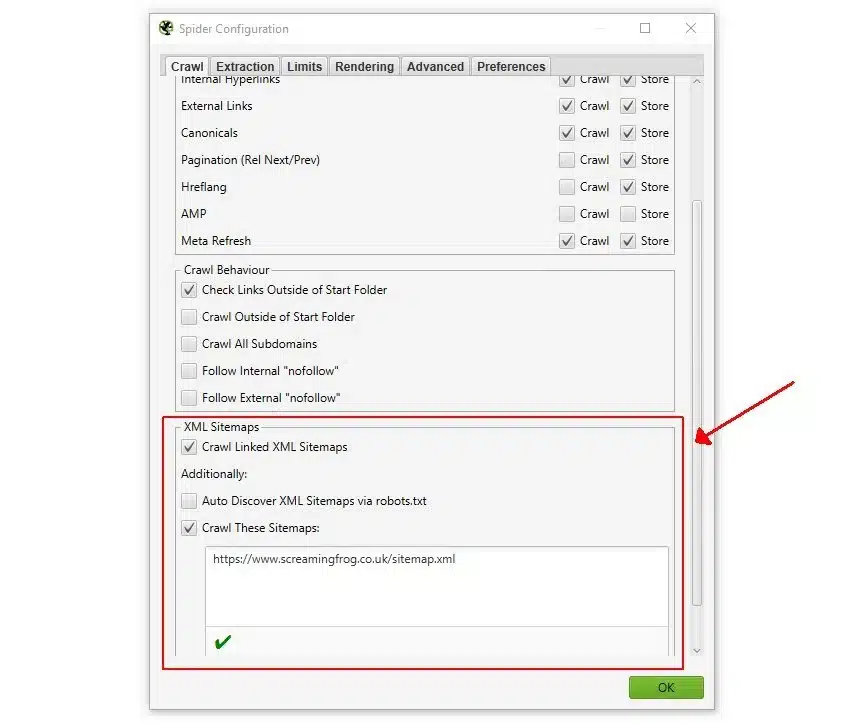

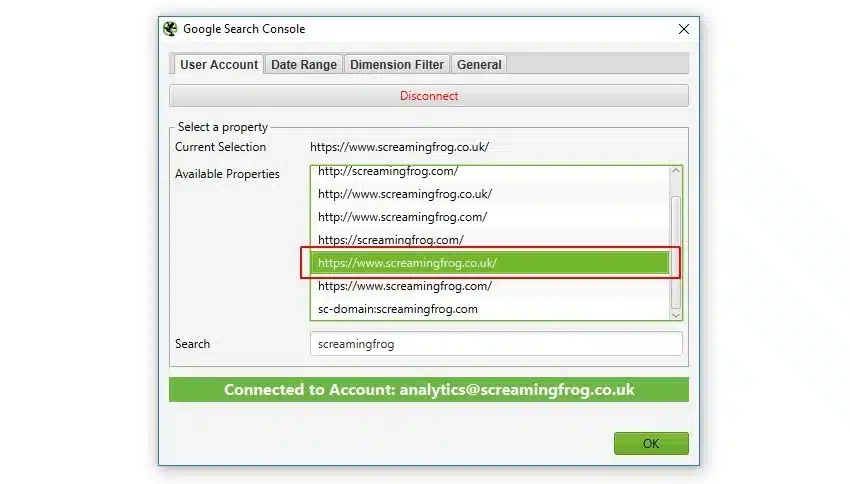

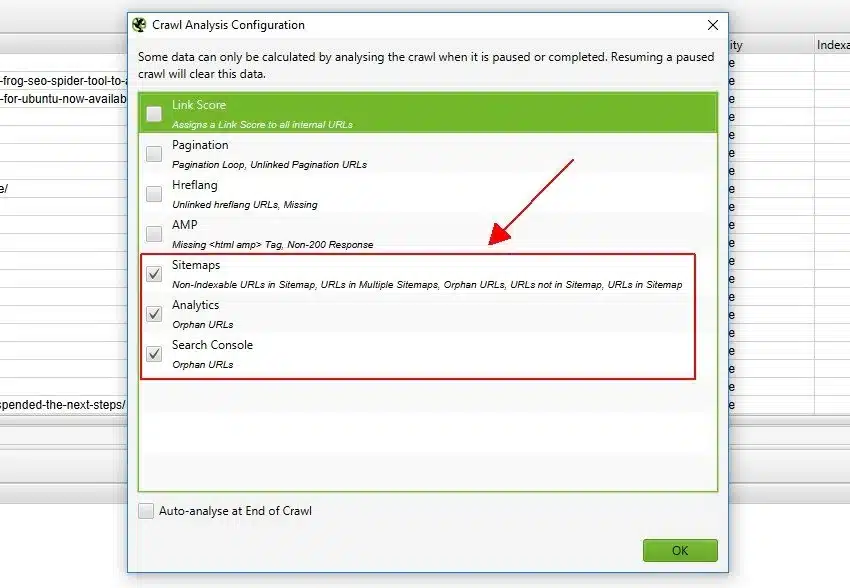

1. Scansionare la Sitemap XML del sito web: ‘Config > Spider > Crawl > Crawl Linked XML Sitemaps’

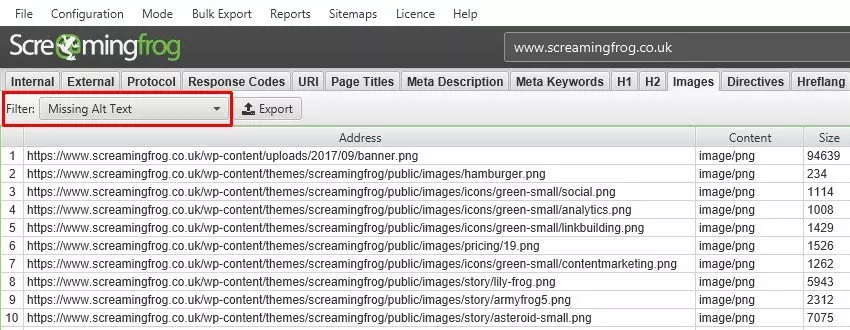

Un’immagine vale più di 1000 parole

Google pone molta attenzione alle immagini e grazie all’intelligenza artificiale riesce a decifrare il contenuto intrinseco dell’immagine stessa.

Un fattore che influenza le valutazioni del Motore di Ricerca è l’attributo “Alt Text” o testo alternativo, ritenuto vitale per aumentare l’accessibilità web agli ipovedenti e non vedenti.

La mancanza di questo attributo può far ignorare completamente l’immagine da parte di Google e rendere inutili i tuoi sforzi nel migliorare il posizionamento.

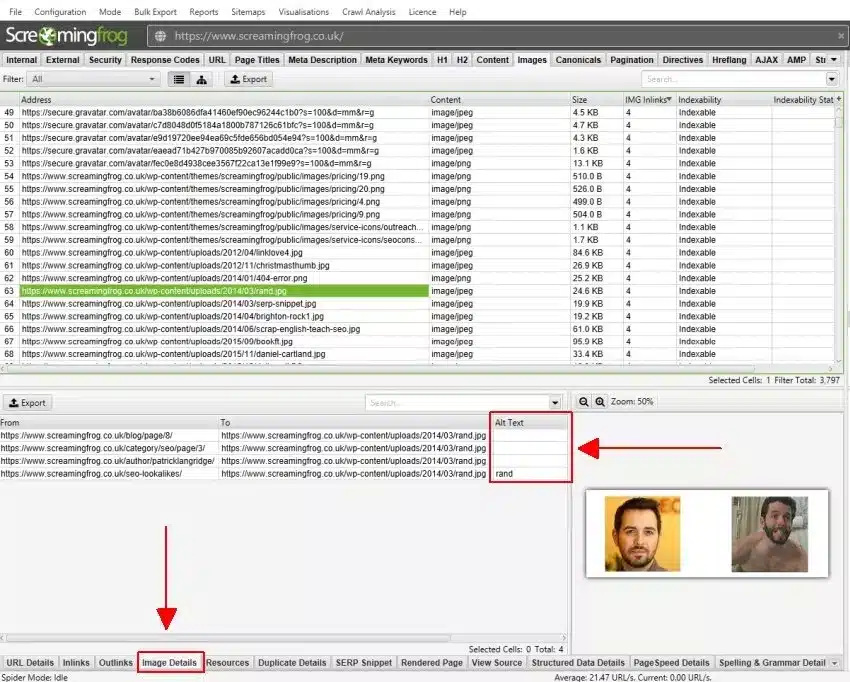

Scopriamo quindi come identificare le risorse che mancano di questo elemento in pochi passi con il Seo Spider:

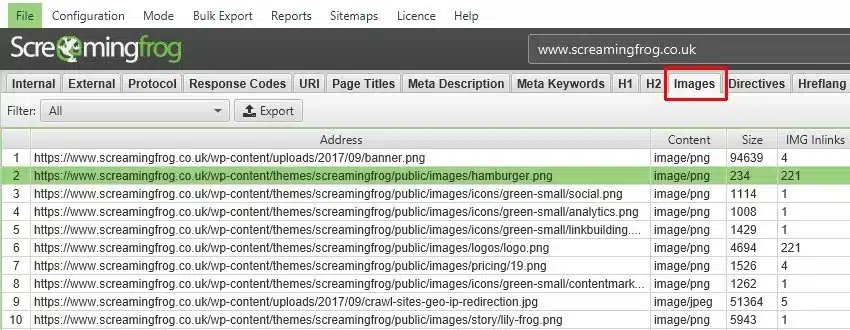

1. Dal menu Spider > Crawl abilita la scansione e il salvataggio delle immagini.

2. Avvia la scansione e consulta la tab “Images” dove troverai tutti i dettagli con gli indirizzi relativi, le dimensioni in termini di peso (Size) e il numero di link IMG di origine.

3. Seleziona una o più URL nella finestra superiore della Tab e clicca sulla scheda “Images Details” in basso, in questo modo otterrai i dettagli sulle pagine di origine (colonna From – l’URL ‘da’) e il corrispettivo Alt Text

Attentə a non ingrassare

Google è molto attento alla linea dei siti web e li vuole belli in forma e performanti. Per questo motivo attraverso il programma di allenamento chiamato Web Vitals sta mettendo a dura prova tutti i Seo e Dev.

Basta carboidrati risorse non utilizzate nel codice, basta zuccheri tempi di caricamento lenti e maggiori performance. Tra i vari indicatori della bilancia di Google c’è il parametro LCP (Largest Contentful Paint) che coinvolge anche le immagini e video presenti sul sito.

Per questi motivi una dieta bilanciata delle immagini con ottimizzazione della “size” è fondamentale per superare il test bikini per il Motore di Ricerca.

Controllare il peso delle tue immagini con Screaming Frog è molto semplice.

1. Dal menu:

a) Spider > Crawl abilita la scansione e il salvataggio delle immagini;

b) Spider > Extract abilita “Page Size”.

2. Visualizza i risultati del Crawl nella tab “Images”. Cliccando sull’header della colonna Size potrai ordinare le immagini in base al peso espresso in Kb.

3. Esporta le immagini da Bulk Export > Images > Images Over X Kb Inlinks o tramite la funzione “Export”.

La prigione del file ROBOTS.TXT

L’errore più comune che un Seo deve sempre verificare per primo! Mi capita sempre più spesso di imbattermi in aziende che mi chiedono: “Perché da quando abbiamo pubblicato il nuovo sito web siamo scomparsi dalla Serp di Google?”.

I motivi possono essere molteplici ma il primo controllo che faccio è quello sul file robots.txt. Molte volte il sito in staging va a sostituire il sito “live” ma il dev o seo si dimentica di aprire le porte a Google.

User-agent: *

Disallow: /

Queste maledette due righe, che in fase di sviluppo ti hanno permesso di evitare le scorribande dello spider dei Motori di Ricerca, se non vengono gestite bloccheranno inesorabilmente la scansione allo Spider.

User-agent: *

Disallow:

Questa condizione è la più comune ed estrema ma può sempre capitare che non tutto il sito sia influenzato ma solamente delle sezioni specifiche.

Per controllare quali risorse vengano bloccate dal file Robots.txt puoi avviare la scansione con il Seo Spider e consultare la Tab “Response Code” applicando il filtro “Blocked by Robots.txt”.

Conclusioni

Di consigli Seo “Non Richiesti” e gestibili con Screaming Frog ce ne sarebbero a centinaia, non ti resta che chiedere a Camilla e allo staff di Humans Agency e iscriverti al mio canale Youtube:

https://www.youtube.com/channel/UCzBajW55HKsufgeWSzsPgoA

Raffaele Visintin, Seo Specialist e founder di Screamingfrog.club, la prima community italiana dedicata a Screaming Frog.